作者/李彦

出品/未来科技界Plus

赛博朋克2077里人机协同的场景,真的要来了。

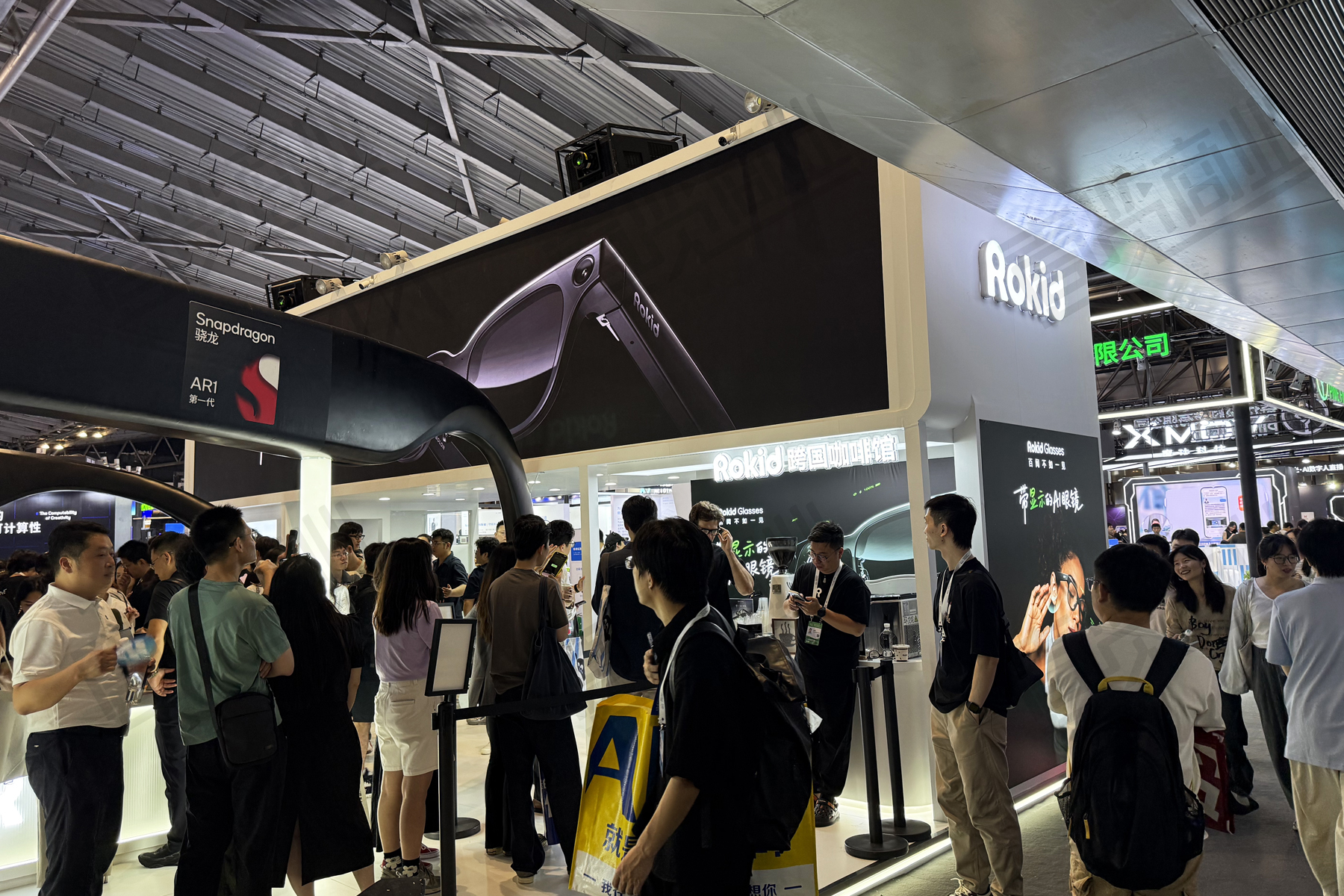

最近,港科大的张军教授和孟子立教授团队主导了一场实验,测试搭载GPT-5.2模型的乐奇AI眼镜在专业课《计算机网络原理》本科期末考试中的表现。在班级平均分72分的情况下,这套AI系统最终拿到92.5分(满分100分),且仅用了半个小时。

这场考试,这位考生和乐奇AI眼镜是这么分工的:考生低头注视试卷,乐奇AI眼镜内置的摄像头(以Rokid Glasses为例,配备的是1200万像素摄像头)就可以完成对试卷拍照和信息采集,再通过配套的手机App自动传输到远端的大模型进行处理,大模型完成题意理解、知识调用和逻辑推理后,将答案沿着同样的路径返回,显示在乐奇AI眼镜的屏幕上,考生落笔答卷。

听到这里,学生们都有些心动了吧?毕竟,这款乐奇AI眼镜在外形上与普通眼镜毫无区别,哪怕你带着去参加考试,监控可能都没法把你抓出来。

但这个实验其实引发了我一个新的思考:在这场实验里,乐奇AI眼镜分担了所有需要“动脑”的工作,虽然说是人机协同完成的一场考试,但人的价值又在哪里?

我认为,在人机协同的新时代,真正稀缺的是提问的能力。

回顾一下我们以往的教育经历,问题通常是被“预设”的:老师是出题人、教材会给例题、考试也有限定范围。在这种体系里,提问只是前置条件,而不是核心能力。

但当 AI 已经可以稳定、低成本地处理这些标准化问题时。谁来定义问题,反而成了决定结果质量的关键变量。同样一张试卷、同样一套模型,得到什么样的答案,很大程度上取决于你在“让 AI 在解决什么问题”。

这也直接抛出了几个新的问题:如果AI 已经可以稳定给出答案,我们是否应该开始系统性地训练学生的提问能力,而不是只训练他们对标准题型的熟练度?当模型输出看起来合理而完整时,学生是否具备足够的批判性评估能力,去识别潜在错误、隐含假设和边界风险?以及,在“人机协同”成为常态之后,我们是否已经建立起一种清晰的机制,让人始终站在决策链的最前端和责任链的最末端?

回看这场考试,它其实提醒了我们:如果我们的教育体系、评价体系和社会分工,仍然只奖励“把既定问题解得更快、更标准”,那么被AI超越只是时间问题;但如果我们开始认真对待那些更难被量化、却更接近“人之为人”的能力,那么人机协同带来的,可能是一轮重新分工后的价值重估。

所以我越来越觉得,每个人都得面对自己的新命题:当AI能替你考试、写论文、做科研,你作为“人”的独特性到底还剩下什么?或许是好奇心?责任感?伦理意识与创造力?这些目前仍难以被编码的品质,才是我们未来更值得关注的特性。

24小时热榜

24小时热榜

热门视频

热门视频